Diagnosi algoritmica, possiamo fidarci di una macchina più che dell’intuito clinico?

L’intelligenza artificiale migliora l’accuratezza diagnostica, ma solleva una domanda cruciale: chi decide davvero quando i dati non bastano?

Matteo Benevento

2/10/2025

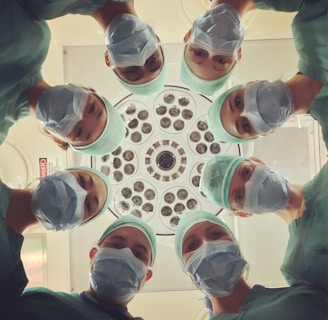

C’è un momento, sempre più frequente, nella medicina contemporanea in cui la diagnosi sembra nascere prima ancora che il medico abbia finito di ragionare. Un’immagine viene caricata su un applicativo specifico, un tracciato analizzato da un software, una serie di dati confrontata con milioni di casi precedenti e l’algoritmo restituisce una risposta. Spesso è precisa, motivata da percentuali elevate, accompagnata da un linguaggio sicuro. In quell’istante si affaccia una domanda che non riguarda solo l’efficacia della tecnologia, ma l’identità stessa della medicina: possiamo fidarci di una macchina più che dell’intuito clinico?

Per capire perché questa domanda sia così centrale, bisogna partire da ciò che la diagnosi è sempre stata. Non un semplice atto di classificazione, ma un processo interpretativo umano. Diagnosticare significa riconoscere un pattern, decidere cosa significhi per quella persona, in quel momento, in quel contesto, in quelle specifiche situazioni in cui si trova. La diagnosi non è mai stata una fotografia statica, bensì una narrazione in costruzione, che si modifica con il tempo, con le informazioni, con la risposta del paziente. L’intelligenza artificiale entra proprio in questo processo portando una potenza analitica senza precedenti, ma anche una visione profondamente diversa. I sistemi di diagnosi algoritmica si basano su modelli di machine learning e deep learning capaci di individuare correlazioni complesse in enormi quantità di dati. In alcuni ambiti, i risultati sono impressionanti. Studi pubblicati su Nature e su The Lancet Digital Health hanno mostrato come algoritmi addestrati su immagini dermatologiche, radiologiche o istopatologiche raggiungano performance paragonabili, e talvolta superiori, a quelle di specialisti esperti. Di fronte a questi dati, la tentazione è quella di considerare l’algoritmo come una forma di sapere più affidabile, più oggettiva, meno soggetta a errore. Ma qui si nasconde l’equivoco profondo. L’accuratezza non coincide con la comprensione. Un algoritmo può riconoscere un pattern con altissima precisione, ma non sa cosa significhi convivere con quella diagnosi. Non conosce la storia del paziente, le sue paure, le sue risorse, le sue priorità. Non può distinguere tra una diagnosi corretta sul piano statistico e una diagnosi appropriata sul piano umano, poiché la diagnosi clinica non è solo una risposta giusta, ma una risposta che deve essere sostenibile per chi la riceve.

L’intuito clinico, spesso liquidato come qualcosa di vago o soggettivo, è in realtà una forma complessa di competenza. Nasce dall’esperienza, dall’esposizione ripetuta a casi reali, dalla capacità di cogliere segnali deboli e incongruenze. Come mostrano gli studi di Pat Croskerry sulla cognizione clinica, l’intuito non è l’opposto della razionalità, ma una sua espressione avanzata, che integra conoscenze esplicite e tacite. È ciò che permette al medico di avvertire che “qualcosa non torna” anche quando i dati sembrano rassicuranti. L’algoritmo, al contrario, lavora sempre all’interno di uno spazio definito dai dati di addestramento. Se un fenomeno non è sufficientemente rappresentato, l’algoritmo fatica a riconoscerlo. Questo limite diventa evidente nei casi atipici, rari o complessi, che sono spesso quelli più difficili anche per la medicina umana. La differenza è che il medico sa di non sapere. L’algoritmo restituisce comunque una risposta, anche quando l’incertezza è elevata.

Un altro elemento cruciale riguarda i bias. Gli algoritmi apprendono dai dati e questi riflettono il mondo così com’è, con le sue disuguaglianze e le sue distorsioni. Studi pubblicati su Science e su JAMA hanno dimostrato come alcuni sistemi di diagnosi e di gestione del rischio abbiano performance diverse in base all’etnia, al genere o al contesto socioeconomico dei pazienti. L’algoritmo non discrimina intenzionalmente, ma può produrre effetti discriminatori se addestrato su dati incompleti o sbilanciati. In questi casi, fidarsi ciecamente della macchina significa accettare una forma di ingiustizia mascherata da oggettività. A complicare ulteriormente il quadro c’è il fenomeno dell’automation bias. Quando una macchina fornisce una risposta rapida e apparentemente autorevole, l’essere umano tende a ridurre il proprio controllo critico. Studi pubblicati su BMJ Quality & Safety mostrano che i clinici possono accettare suggerimenti errati dell’IA anche quando possiedono le competenze per riconoscerli. Il rischio non è solo che l’algoritmo sbagli, ma che il medico smetta di interrogare il risultato, delegando progressivamente il proprio ruolo decisionale. La diagnosi, però, non è mai solo un calcolo. È un atto di responsabilità. Quando un medico comunica una diagnosi, si assume il peso di ciò che quella parola produrrà nella vita del paziente. L’algoritmo non risponde di questo peso. Non accompagna, non ascolta, non sostiene. Per questo, anche quando l’IA “ha ragione”, la decisione di fidarsi o meno resta umana.

Le principali istituzioni internazionali sottolineano questo punto. L’Organizzazione Mondiale della Sanità afferma che l’intelligenza artificiale in sanità deve essere utilizzata come supporto al processo decisionale e non come sostituto del giudizio clinico. Il principio dell’human-in-the-loop non è una formalità tecnica, ma un presidio etico. Serve a garantire che la diagnosi resti un atto interpretativo, situato, responsabile.

Oggi la vera sfida non è stabilire se la macchina sia più affidabile dell’intuito umano, ma capire come le due dimensioni possano dialogare senza annullarsi. Le evidenze più solide mostrano che le migliori performance si ottengono quando medico e algoritmo lavorano insieme. In studi pubblicati su Nature Medicine, la combinazione tra giudizio umano e supporto algoritmico ha ridotto il numero di errori rispetto all’uso isolato di uno dei due. Non perché l’IA renda il medico superfluo, ma perché amplia il campo delle possibilità, lasciando all’umano il compito di interpretare. Questo equilibrio è particolarmente delicato nella formazione dei futuri medici. Imparare a diagnosticare significa imparare a vedere, ma anche a dubitare. Se l’IA diventa una scorciatoia, rischia di indebolire la costruzione dell’intuito clinico. Se invece viene usata come strumento di confronto, può rafforzarlo, rendendo espliciti i passaggi del ragionamento e stimolando una riflessione che sia sempre più critica.

Alla fine, la domanda iniziale trova una risposta che non è né un sì né un no. Non possiamo fidarci di una macchina più che dell’intuito clinico, perché la fiducia non è un rapporto tra dati, ma tra responsabilità. Possiamo però fidarci di un medico che sa usare la macchina senza nascondersi dietro di essa. Di un professionista che accetta l’aiuto dell’algoritmo, ma non rinuncia al proprio giudizio. Di qualcuno che sa riconoscere quando una risposta è tecnicamente corretta ma clinicamente inadeguata. La diagnosi resta sempre un atto umano proprio perché non è riducibile a una probabilità. È una scelta che tiene insieme scienza e relazione, dati e significato, evidenza e incertezza. L’algoritmo può suggerire, indicare, calcolare. Ma fidarsi, davvero, resta una responsabilità che nessuna macchina può assumersi al posto dell’uomo.

PixelPost.it è una testata registrata presso il Tribunale di Roma, n°164 del 15 Dicembre 2023